现在对于网站站长特别是大站来说,是否需要禁止 ChatGPT、Google Bard 等 AI 蜘蛛抓取内容用于训练 AI 处于两难,一是这是一个趋势,生成式 AI 和搜索引擎的融合是必然,而且速度越来越快;二是自己辛辛苦苦写的内容得不到可预期的利益的时候,凭什么被 AI 抓取训练,网站可以获得什么?毕竟 AI 抓取跟搜索引擎抓取内容是不一样的,搜索引擎抓取内容后带给网站流量,而我们网站的内容被 AI 机器人抓取后,网站能得到什么是未知的。

Bing 和 Google 现在都在尝试把生成式 AI 跟搜索引擎融合,也就是 Bing Chat 和 Google的 SGE(Search Generative Experience),在搜索界面体现并给出出处链接,网站可以得到一部分流量,都是位于左下角等不是很突出的位置。不过目前还没有大规模商用,对于网站流量的效果还不明显。

现阶段生成式 AI 跟搜索引擎融合,个人使用感受。

目前在使用中个人分享下三个感受:

一、经过我自己使用 Bing Chat 体验中,我自己是不会点击 AI 回答里的出处链接,AI 可以给出相对完整的结果,而且出处网站链接位置不明显,所以被点击的概率是非常低的。

二、传统的搜索引擎,特别是 Google 和 Bing 不同的网站相对平等,获得流量的机会都相对多;那么 AI 生成的结果,需要特别注意的是喂给生成式 AI 就面临用于训练的资源是不是单一的,或者是不是目前非常强势的网站,比如 CSDN 这类,那其他网站的机会在哪里?是不是会有另外一种 AI 优化的出现?

三、目前生成式 AI 理直气壮、一本正经地胡说,给出错误答案的问题非常突出,对于访客而言,提供一个本身就是错误的答案,不提供其他可供选择的答案,并且正因为用于训练 AI 的数据的封闭性,无法断定给出的结果是否正确?是否有目的的被导向?对于访客是否公平?

怎样禁止 AI 抓取网站内容?

最简单的办法就是 robots.txt 文件禁止,不过 robots.txt 防君子不防小人。

OpenAI 发布 ChatGPT 抓取蜘蛛的新名字- GPTBot,网站可以像禁止其他蜘蛛一样,用 robots 文件禁止 GPTBot 抓取,不过需要注意的是 ChatGPT 的训练数据来源可不一定限于 GPTBot 抓取的数据,除了网上的公开信息,他们还可能使用来自第三方的授权信息,第三方包括社交媒体等,除非立法禁止此类授权被滥用。目前已经有不少大站彻底禁止 GPTBot 抓取。

User-agent: GPTBot Disallow: /

Google 用于AI训练的专用蜘蛛名字: Google-Extended;用 robots 文件禁止了 Google-Extended 蜘蛛,就禁止了 Bard 和 Vertex AI 以及今后所有用于这些产品的模块。所以禁了 Google-Extended 就应该彻底不会被用于 Google AI训练。

User-agent: Google-Extended Disallow: /

CCBot 是非赢利组织 Common Crawl 的蜘蛛,是一个大型网站数据库,很多 AI 是用 CC 数据库来训练的,极有可能是 OpenAI 的第三方数据提供商。

User-agent: CCBot Disallow: /

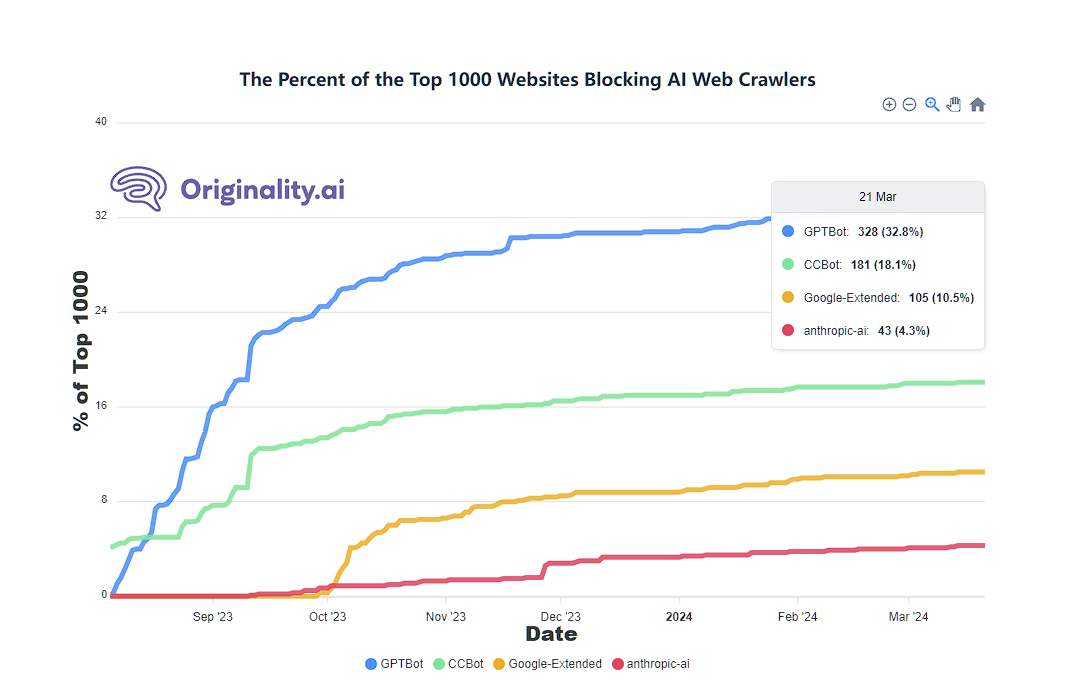

今天看 originality.ai 网站的统计,前1000名大网站,已经有 328 个网站禁止了 GPTBot。大家可以看下下面的数据。

参考文章:

本文TAG: ai抓取数据AI生成错误答案如何追责?AI蜘蛛抓取AI训练数据来源ai训练模型Bing ChatCCBotCCBot数据爬取Common Crawl在AI训练中的作用是什么?Common Crawl数据库Google-ExtendedGoogle-Extended屏蔽GPTBotGPTBot 抓取GPTBot禁止方法originality.ai统计robots.txt编写robots.txt配置指南内容版权与AI训练大站为何纷纷禁止AI蜘蛛?大站反AI抓取趋势如何平衡AI抓取与内容版权?如何禁止ChatGPT的GPTBot抓取?封闭性数据风险屏蔽Google-Extended能阻止AI训练吗?搜索引擎优化搜索引擎优化(SEO)影响是否应该禁止AI抓取网站内容?流量分配不公生成式AI与搜索引擎融合生成式AI会取代传统SEO吗?生成式AI商业伦理生成式AI如何影响站长收益?生成式AI流量转化率生成式AI答案可靠性立法监管AI抓取立法能否解决AI数据滥用问题?站长利益保护第三方数据授权争议网络爬虫抓取个人信息网络爬虫抓取数据

为你推荐

- 2023-11-24如何一键修改 Linux VPS 服务器默认SSH端口?

- 2025-03-27在 WordPress 建站过程中利用 AI 工具提升 SEO 优化效果

- 2024-09-11Jekyllb博客程序,基于Ruby的静态网站生成器

- 2024-06-19一键DD/重装脚本 (One-click reinstall OS on VPS)

- 2025-05-18WordPress 图文并茂搭配这样做,用户爱看、谷歌/Bing/百度搜索引擎爱排

- 2025-04-07内容运营关注核心关键词优化提升SEO排名与精准流量

- 2024-06-23在线小工具网站开源项目:IT Tools;docker 一键搭建

- 2024-03-16使用 CDN 加速后出现 403 Forbidden JSP3/2.0.14 报错怎么解决?