现在对于网站站长特别是大站来说,是否需要禁止 ChatGPT、Google Bard 等 AI 蜘蛛抓取内容用于训练 AI 处于两难,一是这是一个趋势,生成式 AI 和搜索引擎的融合是必然,而且速度越来越快;二是自己辛辛苦苦写的内容得不到可预期的利益的时候,凭什么被 AI 抓取训练,网站可以获得什么?毕竟 AI 抓取跟搜索引擎抓取内容是不一样的,搜索引擎抓取内容后带给网站流量,而我们网站的内容被 AI 机器人抓取后,网站能得到什么是未知的。

Bing 和 Google 现在都在尝试把生成式 AI 跟搜索引擎融合,也就是 Bing Chat 和 Google的 SGE(Search Generative Experience),在搜索界面体现并给出出处链接,网站可以得到一部分流量,都是位于左下角等不是很突出的位置。不过目前还没有大规模商用,对于网站流量的效果还不明显。

现阶段生成式 AI 跟搜索引擎融合,个人使用感受。

目前在使用中个人分享下三个感受:

一、经过我自己使用 Bing Chat 体验中,我自己是不会点击 AI 回答里的出处链接,AI 可以给出相对完整的结果,而且出处网站链接位置不明显,所以被点击的概率是非常低的。

二、传统的搜索引擎,特别是 Google 和 Bing 不同的网站相对平等,获得流量的机会都相对多;那么 AI 生成的结果,需要特别注意的是喂给生成式 AI 就面临用于训练的资源是不是单一的,或者是不是目前非常强势的网站,比如 CSDN 这类,那其他网站的机会在哪里?是不是会有另外一种 AI 优化的出现?

三、目前生成式 AI 理直气壮、一本正经地胡说,给出错误答案的问题非常突出,对于访客而言,提供一个本身就是错误的答案,不提供其他可供选择的答案,并且正因为用于训练 AI 的数据的封闭性,无法断定给出的结果是否正确?是否有目的的被导向?对于访客是否公平?

怎样禁止 AI 抓取网站内容?

最简单的办法就是 robots.txt 文件禁止,不过 robots.txt 防君子不防小人。

OpenAI 发布 ChatGPT 抓取蜘蛛的新名字- GPTBot,网站可以像禁止其他蜘蛛一样,用 robots 文件禁止 GPTBot 抓取,不过需要注意的是 ChatGPT 的训练数据来源可不一定限于 GPTBot 抓取的数据,除了网上的公开信息,他们还可能使用来自第三方的授权信息,第三方包括社交媒体等,除非立法禁止此类授权被滥用。目前已经有不少大站彻底禁止 GPTBot 抓取。

User-agent: GPTBot Disallow: /

Google 用于AI训练的专用蜘蛛名字: Google-Extended;用 robots 文件禁止了 Google-Extended 蜘蛛,就禁止了 Bard 和 Vertex AI 以及今后所有用于这些产品的模块。所以禁了 Google-Extended 就应该彻底不会被用于 Google AI训练。

User-agent: Google-Extended Disallow: /

CCBot 是非赢利组织 Common Crawl 的蜘蛛,是一个大型网站数据库,很多 AI 是用 CC 数据库来训练的,极有可能是 OpenAI 的第三方数据提供商。

User-agent: CCBot Disallow: /

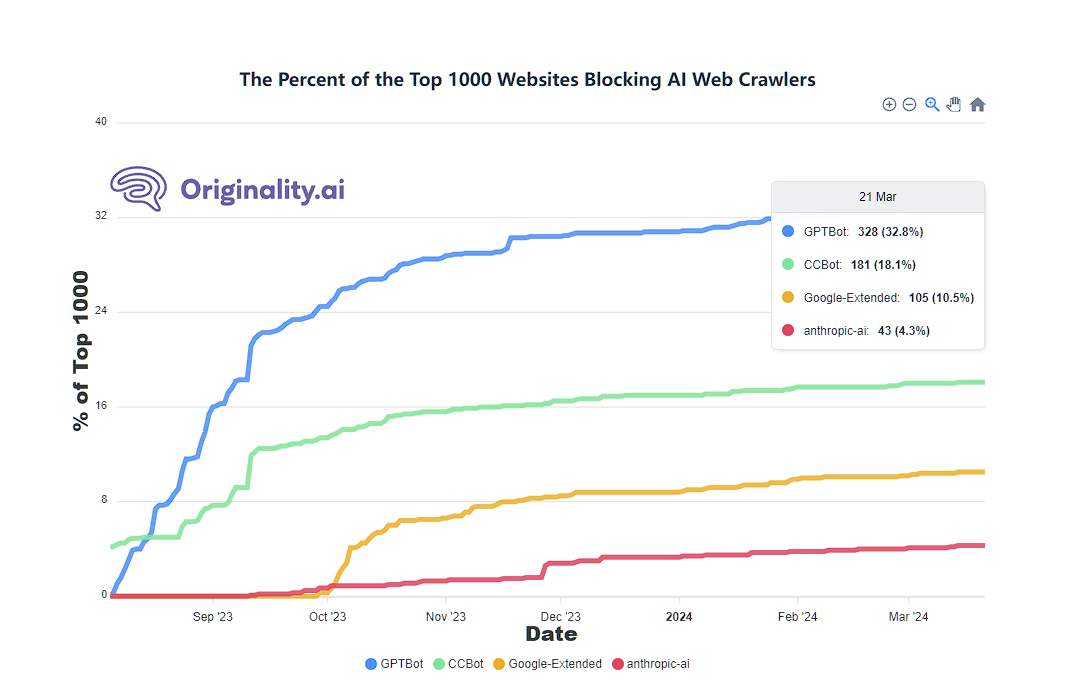

今天看 originality.ai 网站的统计,前1000名大网站,已经有 328 个网站禁止了 GPTBot。大家可以看下下面的数据。

参考文章:

转载请注明:VPS站长网 » 如何禁止网站内容被抓取用于 AI 训练?有必要禁止吗?